Big Data

Saking seringnya ngobrol tentang Big Data dengan beberapa kalangan, lama lama saya mulai bisa memetakan kebingungan, kegalauan, dan pemahaman masyarakat mengenai topik ini. Kebanyakan masyarakat yang awam dengan Big Data, sering tidak bisa mendefinisikan dengan tepat apa itu Big Data. Mereka hanya tahu bagian input dan output saja .. proses di tengahnya gelap seperti blackbox. Bahkan beberapa rekan dosen yang masih awam bilang, coba selesaikan masalah penelitian dengan Big Data (maksudnya sih mengambil data dari media sosial), sementara yang lain menggangap bahwa Big Data itu metode pengganti statistik yang lebih canggih. Tentu saja anggapan anggapan tersebut tidak benar, kita semua mengenal istilah Big Data ini, karena ada peluang tersedianya data dalam jumlah besar, sehingga muncul peluang untuk memanfaatkannya. Perkara apakah hasil riset menggunakan Big Data akan lebih baik dari hasil metode konvensional (statistik), yah belum tentu juga.

Jadi Big Data itu apa ?, metode, alat, media atau yang hal lainnya yang kompleks, tidak masuk dalam kategori yang bisa dipahami (rumit), maka dimasukkan ke dalam Big Data. Lucunya ini kenyataan lho, bahkan misalkan proses optimasi, simulasi, dan model matematika yang sudah ada sejak dulu, sering dianggap sebagai bagian Big Data juga, hanya karena metode itu saat ini sering digunakan (untuk menyelesaikan masalah kompleks) karena ketersediaan data yang semakin mudah. Sisi bagusnya adalah metode metode seperti artificial neural network, simulasi monte carlo, simulated annealing, dan lain lainnya semakin sering dipergunakan dan semakin dikenal.

Data Science

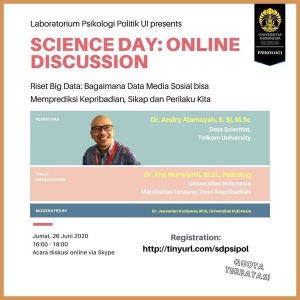

Supaya tidak terjebak istilah Big Data yang ambigu, maka saya sarankan kita bicaranya dari sisi Data Science saja. Data Science adalah suatu ilmu yang berpusat pada data sebagai komoditi utamanya. Beberapa metode dan kepentingan dari latar belakang kelimuan yang berbeda digunakan. Ilmu ilmu tersebut antara lain adalah ilmu komputer, matematika / statistika, bisnis, dan domain / konteks permasalahan. Orang / talentanya disebut sebagai Data Scientist, dalam bahasa Indonesia adalah Ilmuwan Data. Kebetulan saya dan beberapa rekan ilmuwan serta praktisi membuat wadah Asosiasi Ilmuwan Data Indonesia (AIDI) (silahkan dicek, boleh kok bergabung). Masih ingat postingan saya beberapa tahun yang lalu tentang tulisan Davenport dan DJ Patil di HBR bahwa “Data Scientist is the most sexiest job in 21th century” pada tahun 2012. Ternyata 5 – 6 tahun kemudian tetap sexy lho, cek disini dan disini.

Karena begitu sexy nya profesi ini, maka saya mulai melakukan riset kecil kecilan, kenapa profesi ini begitu dicari. Industri begitu kesulitan, dan bahkan putus asa mencari talenta yang bisa melakukan analisa, menceritakan pola dari data, dan membuat prediksi. Karena latar belakang pendidikan lulusan universitas pada umumnya sering terkotak kotak pada kelompok keilmuan tertentu, dan belum bisa berkomunikasi dengan bidang lain. Sebagai gambaran, daripada memberi gaji 1x ke programmer, 1x ke modeler, dan 1x ke orang bisnis (total 3x gaji), lebih baik perusahaan memberikan gaji 5x ke 1 orang yang menguasai ketiga domain tersebut. Nah talenta / orang ini yang disebut sebagai Data Scientist.

Pemetaan Data Scientist

Data Analytics Body of Knowledge

Data Science Knowledge Area

Data Engineering Body of Knowledge

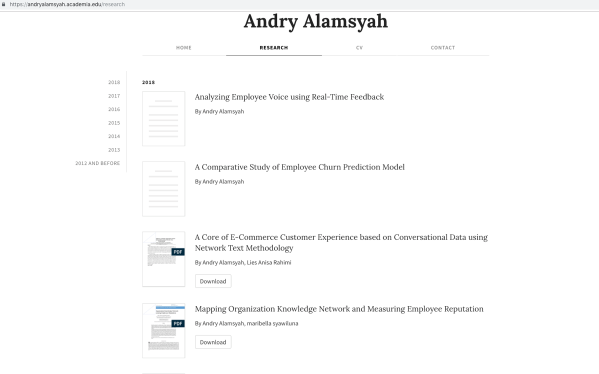

Hasil baca sana sini, diperolah bahwa seorang Data Scientist itu harus mempunyai Knowledge Area (area pengetahuan) di bidang Data Analytics, Data Engineering, Data Management, Research Methodology, Project Management, Business Analytics, dan Domain Knowledge. Masing masing dari area pengetahuan diatas dibagi lagi menjadi keilmuan keilmuan kecil yang disebut sebagai Body of Knowledge (BoK) yang diselaraskan dengan cabang keilmuan, sehingga kita bisa identifikasi keilmuan besarnya masuk ke dalam ilmu apa. Peta sementara dari 3 gambar diatas, menunjukkan betapa kompleksnya keilmuan data tersebut, tidak salah kalo memang pekerjaan ini disebut pekerjaan sexy.

Oh ya sebagai penutup blog singkat ini. Dari segitu banyak “maunya” industri mencari talenta Data Scientist yang canggih, sampai saat ini belum terlihat adanya daftar / framework kompetensi dari seorang Data Scientist yang diinginkan oleh industri, atau bahkan kompetensi secara global. Ini menjadi PR penting dalam rangka mengurangi gap antara lulusan universitas dan industri.